Introduction à l’autoscaling dans Kubernetes

L’autoscaling est une fonctionnalité clé de Kubernetes qui permet d’adapter dynamiquement le nombre de pods en fonction de la demande. Dans un environnement cloud, la gestion efficiente des ressources est cruciale pour maintenir la performance des applications tout en optimisant les coûts. Les ressources cloud, telles que le CPU et la mémoire, peuvent facilement devenir des goulets d’étranglement si elles ne sont pas gérées correctement. L’autoscaling aide à surmonter ces défis en augmentant ou en diminuant le nombre de Pods en fonction des besoins réels de l’application.

Kubernetes offre plusieurs méthodes d’autoscaling, parmi lesquelles on trouve le Horizontal Pod Autoscaler (HPA) et Keda. Le HPA ajuste le nombre de pods en fonction de métriques observables comme l’utilisation du CPU ou d’autres métriques personnalisées, permettant ainsi une réaction rapide aux changements de charge. Il est particulièrement efficace pour les applications qui présentent des variations prévisibles de la charge. Il lui faut un pod au minimum.

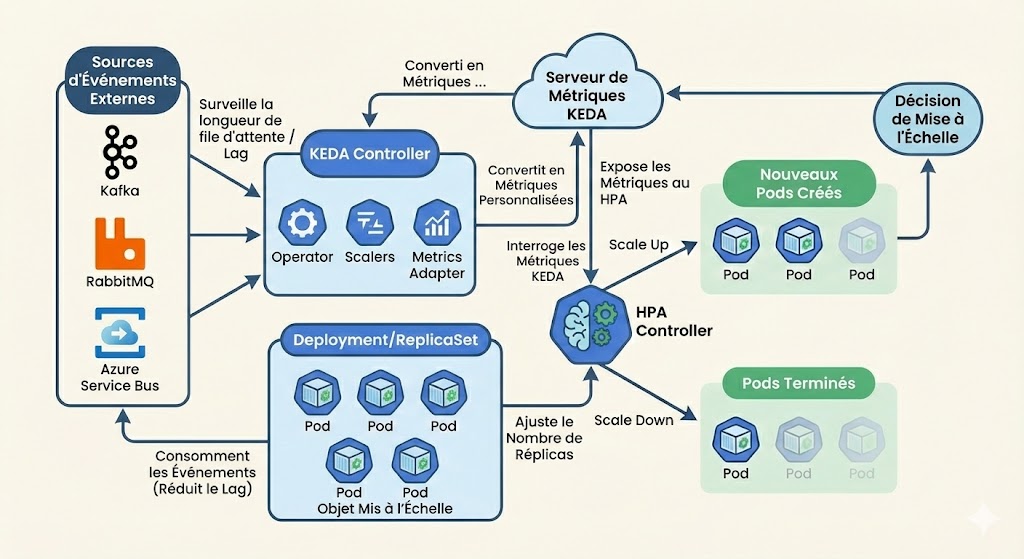

D’un autre côté, Keda (Kubernetes Event-driven Autoscaling) se distingue par sa capacité à intégrer des événements provenant de sources externes pour piloter l’autoscaling. Contrairement au HPA, qui repose principalement sur les métriques internes, Keda peut déclencher une montée en charge basée sur des événements de différentes plateformes comme Azure Service Bus, Kafka, RabbitMQ, ou même des requêtes HTTP. Cette flexibilité permet aux développeurs de répondre non seulement à une charge de travail accrue, mais aussi à des variations plus subtiles, rendant l’autoscaling encore plus réactif et efficace. Il peut éteindre l’ensemble de ses pods contrairement au HPA.

Keda : Présentation et fonctionnement

Keda, ou Kubernetes Event-driven Autoscaling, est une solution d’autoscaling qui se distingue par sa capacité à réagir à des événements externes, ce qui en fait un outil puissant pour les applications modernes. Contrairement à des solutions traditionnelles comme l’HORIZONTAL POD AUTOSCALER (HPA), Keda permet d’ajuster dynamiquement le nombre de pods en fonction de la demande, non seulement en fonction des métriques internes de l’application, mais également grâce à des déclencheurs basés sur des événements provenant de diverses sources externes.

Le fonctionnement de Keda repose sur des **scalers**, qui surveillent des éléments tels que les files d’attente de messages, les bases de données et d’autres systèmes d’événements. Lorsqu’un seuil défini est atteint, Keda active une montée en charge en adaptant le nombre de pods en conséquence. Cela signifie qu’une application peut se dimensionner automatiquement en réponse à une augmentation du trafic ou d’événements spécifiques, sans nécessiter d’interventions manuelles.

Parmi les caractéristiques clés de Keda, son intégration avec des systèmes de messagerie tels que Azure Service Bus, Kafka ou RabbitMQ est particulièrement notable. Cela permet non seulement une réponse rapide aux pics de demande, mais également une gestion efficace des ressources, évitant ainsi une sur-provision d’instances. En comparaison avec d’autres solutions d’autoscaling, Keda se révèle plus flexible, car il gère des charges de travail variées qui ne sont pas exclusivement basées sur des métriques internes.

Cette capacité à réagir à des événements et à des seuils dynamiques en fait une option idéale pour les architectures orientées microservices et les applications basées sur des événements, où la scalabilité doit être synchrone avec les fluctuations d’activité en temps réel.

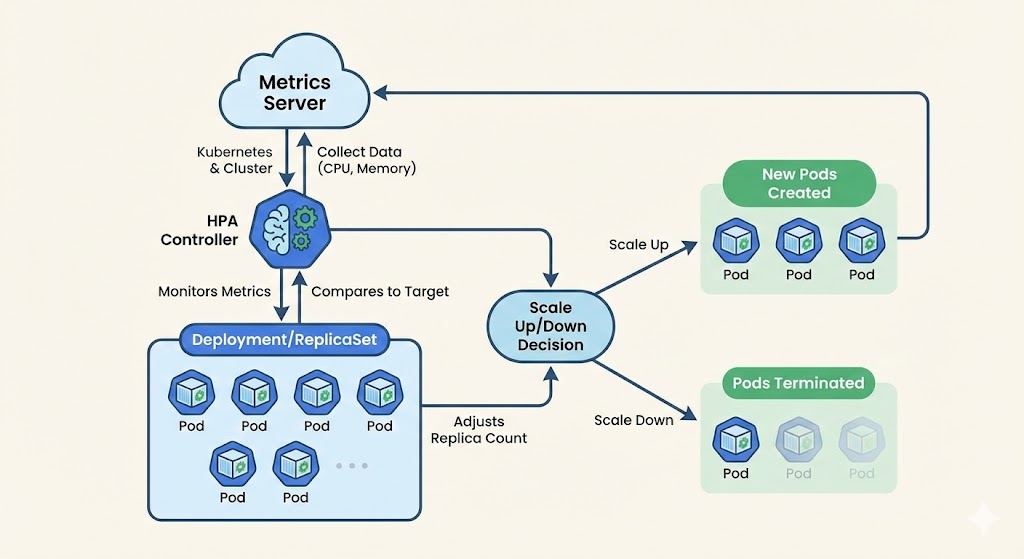

HPA : Fonctionnement et avantages

L’HPA, ou Horizontal Pod Autoscaler, est une fonction intégrée à Kubernetes, conçue pour ajuster automatiquement le nombre de pods en fonction de la charge de travail. Grâce à des métriques de performance, telles que l’utilisation de la CPU ou la mémoire, l’HPA surveille en continu l’état des pods et effectue des ajustements dynamiques. Par exemple, si la charge d’un service augmente, l’HPA peut augmenter le nombre de pods afin de maintenir les performances et de répondre à la demande utilisateur.

Les principaux avantages de l’HPA résident dans sa simplicité d’utilisation et sa capacité à s’intégrer de manière transparente dans l’écosystème Kubernetes. Cette solution est idéale pour des cas d’utilisation typiques, tels que les applications web, où la charge peut varier considérablement en fonction des heures de pointe. L’HPA permet également d’optimiser les ressources en réduisant le nombre de pods lorsque la demande diminue, contribuant ainsi à la réduction des coûts opérationnels.

En comparaison avec Keda, l’HPA se limite principalement à des métriques internes de Kubernetes, tandis que Keda offre une capacité d’autoscaling basée sur des événements externes, comme les messages dans une file d’attente. Bien que l’HPA fonctionne impeccablement dans des scénarios où les métriques standards suffisent, il peut s’avérer moins flexible face à des charges de travail plus variées, où Keda pourrait apporter un soutien plus réactif et adapté.

Comparaison entre Keda et HPA

HPA (Horizontal Pod Autoscaler)

Fonctionnement : Il ajuste le nombre de pods principalement en fonction de l’utilisation des ressources physiques comme le CPU ou la mémoire.

Avantages : Étant intégré nativement à Kubernetes, son adoption est simplifiée et nécessite peu de configurations supplémentaires.

- Inconvénient : Minimum 1 pod actif. Le HPA a besoin qu’un pod tourne pour mesurer son CPU/RAM et décider de scaler.

Usage idéal : Il est particulièrement bien adapté aux applications dont la charge de travail est stable.

Keda (Kubernetes Event-driven Autoscaling)

Fonctionnement : Il permet un autoscaling basé sur des événements spécifiques (messages en file d’attente, signaux de bases de données, etc.) en plus des ressources standards.

Avantages : Offre une flexibilité et une capacité d’adaptation supérieures pour les architectures événementielles, Coût zéro quand il n’y a pas d’activité (approche Serverless).

Usage idéal : Il est recommandé pour les applications ayant des charges de travail sporadiques ou imprévisibles.

Inconvénients : Sa mise en œuvre est plus complexe et peut augmenter la difficulté de gestion opérationnelle.

Synthèse pour le choix

Simplicité : Si l’application nécessite un autoscaling traditionnel basé sur les ressources, HPA est le choix le plus direct.

Performance avancée : Pour des besoins complexes liés à des événements externes, Keda est la solution optimale.

Objectif final : La décision dépend des besoins spécifiques de l’application pour optimiser l’infrastructure face à une charge variable.

- FINOPS : Le « Scale-to-Zero » : La différence fondamentale, KEDA Peut descendre à 0 pod. Il surveille la source externe (ex: une file RabbitMQ) et non le pod lui-même.

Conclusion OPS

En comparant Keda et HPA, nous avons mis en lumière les distinctions clés entre ces deux solutions d’autoscaling.

Le choix entre Keda et HPA dépendra des besoins spécifiques de chaque application.

En comprenant leurs fonctionnalités, tu pourras optimiser les infrastructures Kubernetes pour répondre à une charge de travail variable.